OpenAI官方推出AI生成内容识别器,但成功率只有26%,网友:还不如论文查重工具(组图)

很多人也许已经忘记,ChatGPT 正式发布时间是去年 11 月底,到现在才刚刚两个月,但它掀起的热潮却已引发科技公司纷纷跟进,催生了独角兽创业公司,还让学术界修改了论文接收的要求。

在 ChatGPT 引发 AI 领域「是否要禁用」大讨论之后,OpenAI 的真假鉴别工具终于来了。1 月 31 日,OpenAI 官宣了区分人类作品和 AI 生成文本的识别工具上线,该技术旨在识别自家的 ChatGPT、GPT-3 等模型生成的内容。

然而分类器目前看起来准确性堪忧:OpenAI 在博客里指出 AI 识别 AI 高置信度正确率约为 26%。

但该机构认为,当它与其他方法结合使用时,可以有助于防止 AI 文本生成器被滥用。「我们提出分类器的目的是帮助减少人工智能生成的文本造成的混淆。然而它仍然有一些局限性,因此它应该被用作其他确定文本来源方法的补充,而不是作为主要的决策工具,」OpenAI 发言人通过电子邮件对媒体介绍道。

「我们正通过这个初始分类器获取有关此类工具是否有用的反馈,并希望在未来分享改进的方法。」最近科技领域随着围绕生成式 AI,尤其是文本生成 AI 的热情正在不断增长,但相对的是人们对于滥用的担忧,批评者呼吁这些工具的创造者应该采取措施减轻其潜在的有害影响。

面对海量的 AI 生成内容,一些行业立刻作出了限制,美国一些最大的学区已禁止在其网络和设备上使用 ChatGPT,担心会影响学生的学习和该工具生成的内容的准确性。包括 Stack Overflow 在内的网站也已禁止用户共享 ChatGPT 生成的内容,称人工智能会让用户在正常的讨论中被无用内容淹没。

这些情况突出了 AI 识别工具的必要性。虽然效果不尽如人意,但 OpenAI AI 文本分类器(OpenAI AI Text Classifier)在架构上实现了和 GPT 系列的对标。它和 ChatGPT 一样是一种语言模型,是根据来自网络的许多公开文本示例进行训练的。与 ChatGPT 不同的是,它经过微调可以预测一段文本由 AI 生成的可能性 —— 不仅来自 ChatGPT,也包括来自任何文本生成 AI 模型的内容。具体来说,OpenAI 在来自五个不同组织(包括 OpenAI 自己)的 34 个文本生成系统的文本上训练了 AI 文本分类器。这些内容与维基百科中相似(但不完全相同)的人工文本、从 Reddit 上共享的链接中提取的网站以及为 OpenAI 文本生成系统收集的一组「人类演示」配对。

需要注意的是,OpenAI 文本分类器不适用于所有类型的文本。被检测的内容至少需要 1000 个字符,或大约 150 到 250 个单词。它没有论文检测平台那样的查重能力 —— 考虑到文本生成人工智能已被证明会照抄训练集里的「正确答案」,这是一个非常难受的限制。OpenAI 表示,由于其英语前向数据集,它更有可能在儿童或非英语语言书写的文本上出错。在评估一段给定的文本是否由 AI 生成时,检测器不会正面回答是或否。

根据其置信度,它会将文本标记为「非常不可能」由 AI 生成(小于 10% 的可能性)、「不太可能」由 AI 生成(在 10% 到 45% 之间的可能性)、「不清楚它是否是」AI 生成(45% 到 90% 的机会)、「可能」由 AI 生成(90% 到 98% 的机会)或「很有可能」由 AI 生成(超过 98% 的机会)。看起来和图像识别的 AI 很像,除了准确程度。根据 OpenAI 的说法,分类器错误地将人类编写的文本标记为 AI 编写的文本的概率为 9%。

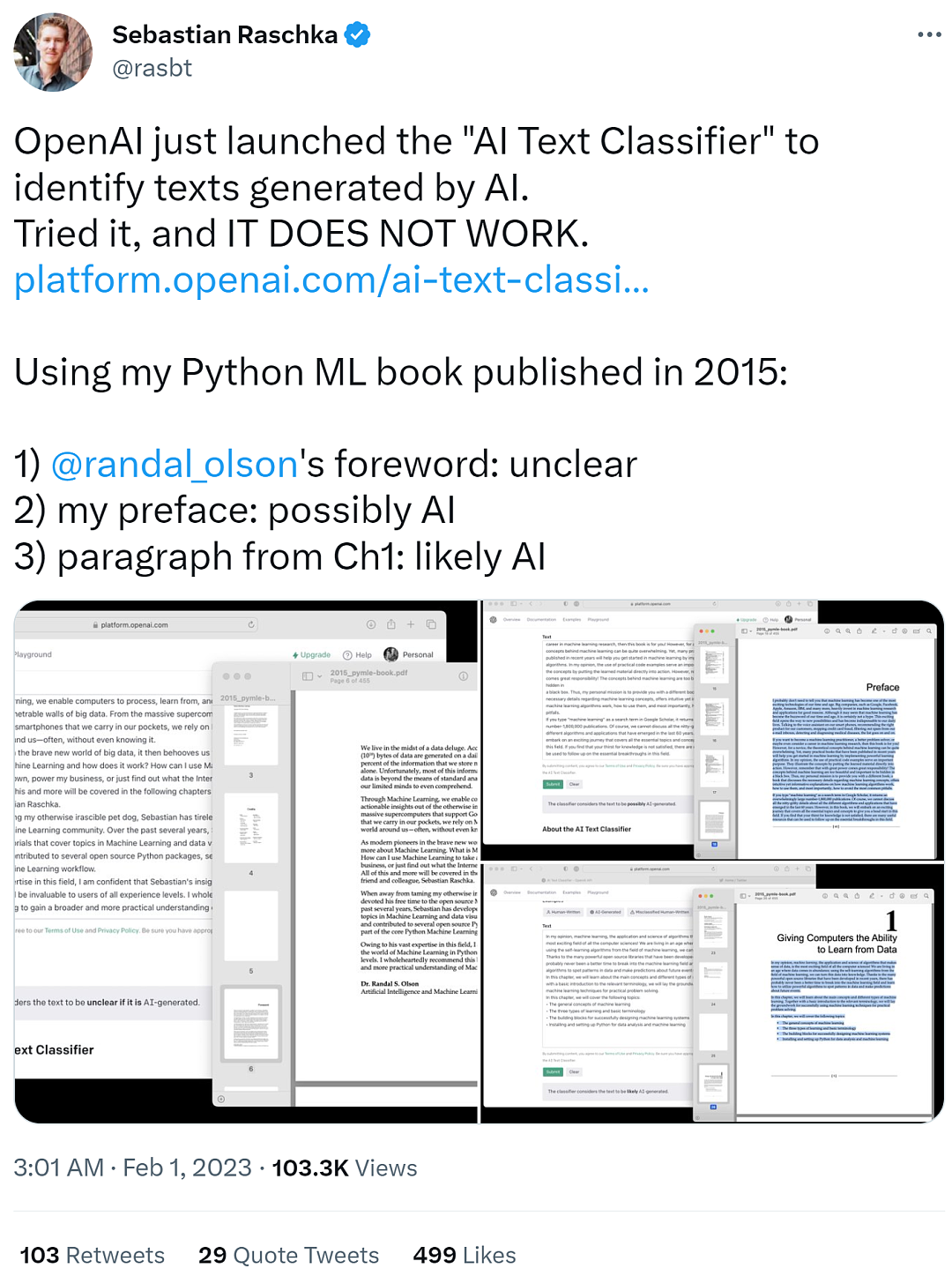

一番试用之后,效果的确不大行OpenAI 宣称其 AI 文本分类器的成功率约为 26%,一些网友上手试用之后,发现识别效果果然不行。知名 ML 和 AI 研究人员 Sebastian Raschka 试用之后,给出了「It does not work」的评价。他使用其 2015 年初版的 Python ML 书籍作为输入文本,结果显示如下。

Randy Olson 的 foreword 部分被识别为不清楚是否由 AI 生成(unclear)

他自己的 preface 部分被识别为可能由 AI 生成(possibly AI)

第一章的段落部分被识别为很可能由 AI 生成(likely AI)

Sebastian Raschka 对此表示,这是一个有趣的例子,但自己已经为将来可能因离谱的论文识别结果而受到惩罚的学生感到难过了。

因此他提议,如果要部署这样的模型,请共享一个混淆矩阵。不然如果教育者采用这一模型进行评分,则可能会对现实世界造成伤害。此外还应该增加一些有关误报和漏报的透明度。

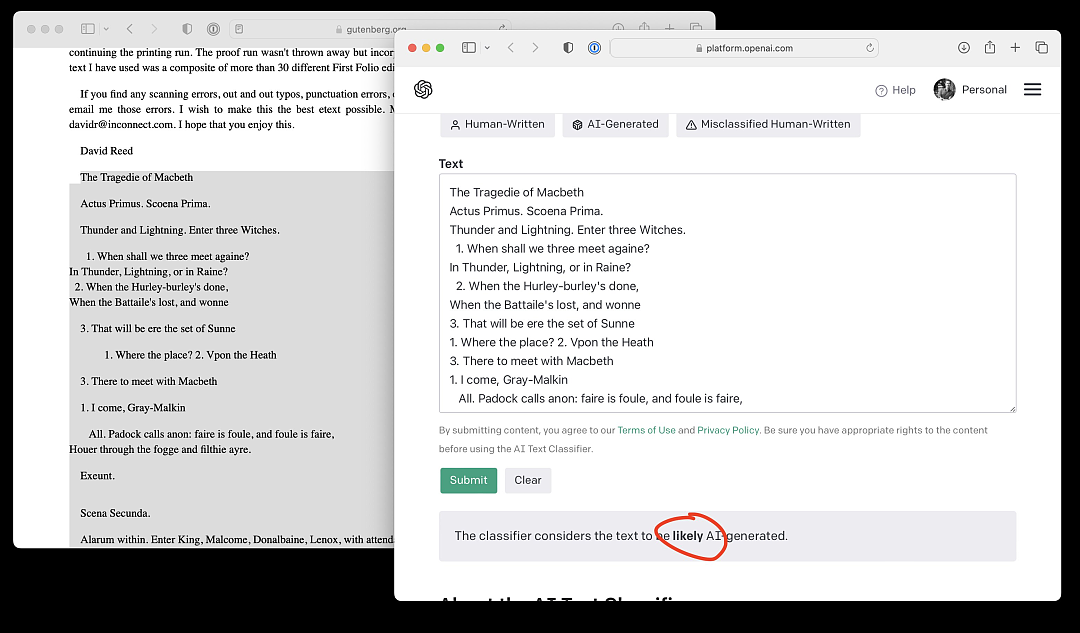

此外,Sebastian Raschka 输入了莎士比亚《麦克白》第一页的内容,OpenAI AI 文本分类器给出的结果竟然是很可能由 AI 生成。简直离谱!

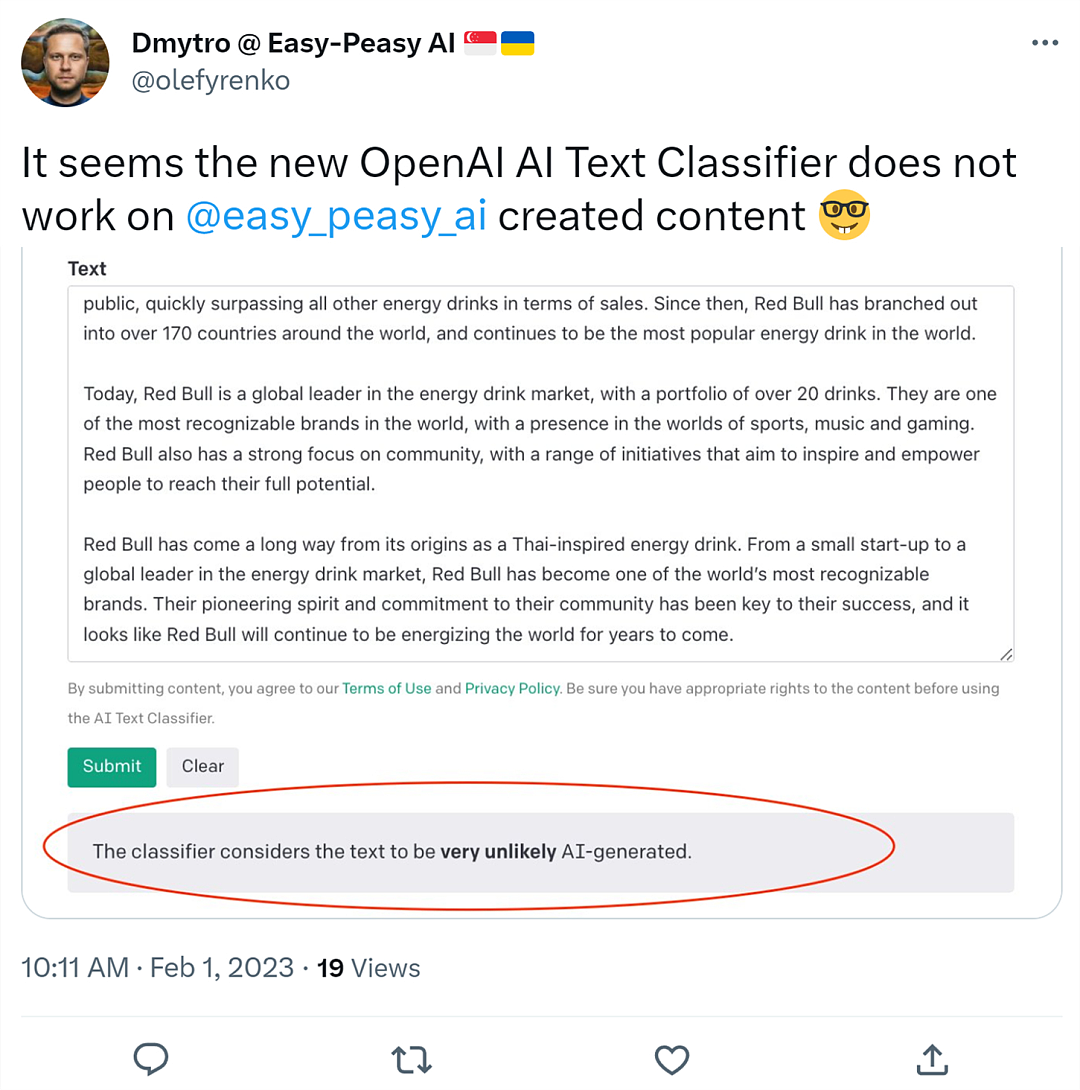

还有人上传了 AI 写作工具 Easy-Peasy.AI 创作的内容,结果 OpenAI AI 文本分类器判定为由 AI 生成的可能性非常小。

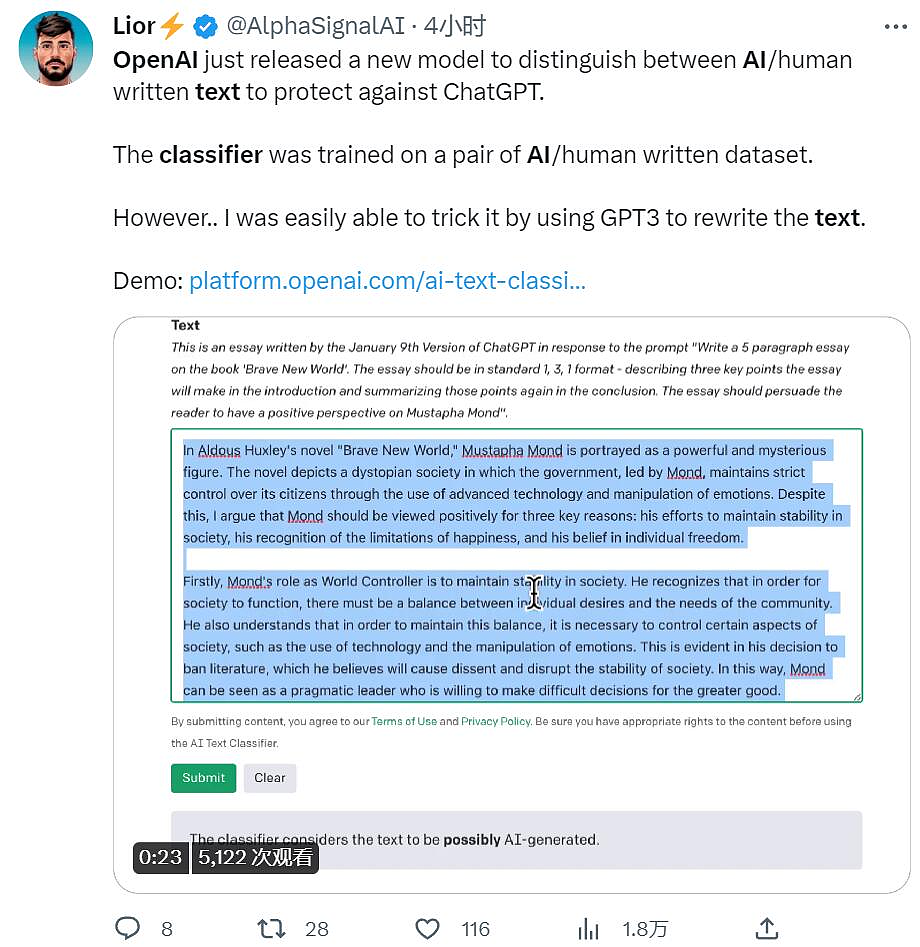

最后,有人用上了反复翻译大法,把文本让 GPT3 重写一遍,也能骗过识别器。

总结一下的话就是正向识别不准,反向识别出错,也无法识破一些改论文的技巧。看来,起码在 AI 文本内容识别这一领域,OpenAI 还需努力。

+61

+61 +86

+86 +886

+886 +852

+852 +853

+853 +64

+64